반응형

15.1 BERT 학습을 위한 전처리

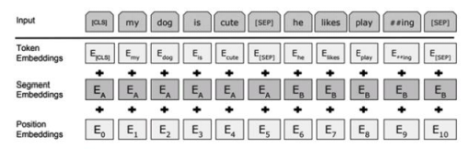

- 토큰 임베딩

- 구간 임베딩

- 위치 임베딩

from transformers import BertTokenizer

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

sentence1 = "What a beautiful day!"

sentence2 = "Nvidia Titan XP has 12GB of VRAM"

# 1. 토큰화 결과

print(sentence1, '토큰화 결과:', tokenizer.tokenize(sentence1))

print(sentence2, '토큰화 결과:', tokenizer.tokenize(sentence2))

"""

What a beautiful day! 토큰화 결과: ['what', 'a', 'beautiful', 'day', '!']

Nvidia Titan XP has 12GB of VRAM 토큰화 결과: ['n', '##vid', '##ia', 'titan', 'xp', 'has', '12', '##gb', 'of', 'vr', '##am']

"""# 2. BERT 모형 입력 생성

inputs = tokenizer([sentence1, sentence2], padding=True)

print('BERT 입력:', inputs)

"""

BERT 입력: {'input_ids': [[101, 2054, 1037, 3376, 2154, 999, 102, 0, 0, 0, 0, 0, 0], [101, 1050, 17258, 2401, 16537, 26726, 2038, 2260, 18259, 1997, 27830, 3286, 102]], 'token_type_ids': [[0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0], [0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0]], 'attention_mask': [[1, 1, 1, 1, 1, 1, 1, 0, 0, 0, 0, 0, 0], [1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1]]}

"""# 3. 두 문장으로 이루어진 시퀀스에 대한 BERT 모형 입력 생성

inputs = tokenizer(sentence1, sentence2, padding=True)

print('두 문장 시퀀스에 대한 BERT 입력:', inputs)

"""

두 문장 시퀀스에 대한 BERT 입력: {'input_ids': [101, 2054, 1037, 3376, 2154, 999, 102, 1050, 17258, 2401, 16537, 26726, 2038, 2260, 18259, 1997, 27830, 3286, 102], 'token_type_ids': [0, 0, 0, 0, 0, 0, 0, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1], 'attention_mask': [1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1]}

"""

※ 해당 내용은 <파이썬 텍스트 마이닝 완벽 가이드>의 내용을 토대로 학습하며 정리한 내용입니다.

반응형

'텍스트 마이닝' 카테고리의 다른 글

| BERT 사전학습 모형에 대한 미세조정학습 (3) (0) | 2023.08.04 |

|---|---|

| BERT 사전학습 모형에 대한 미세조정학습 (2) (0) | 2023.08.03 |

| BERT의 이해와 간단한 활용 (2) (0) | 2023.08.01 |

| BERT의 이해와 간단한 활용 (1) (0) | 2023.07.31 |

| 어텐션(Attention)과 트랜스포머 (2) (0) | 2023.07.30 |