반응형

14.1 왜 언어 모델이 중요한가?

- 언어 모델: 문장 혹은 단어의 시퀀스에 대해 확률을 할당하는 모델

- GPT(Generative Pre-trained Transformer)가 언어 모델로 학습한 대표적인 모형

14.2 BERT의 구조

- BERT는 언어 모델 기반의 학습을 이용해 언어에 대한 이해를 높이는 데 목적이 있음

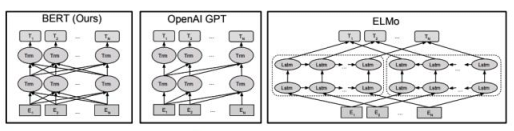

- GPT가 단방향 혹은 순방향으로만 셀프 어텐션만 사용하는 것에 비해 BERT는 양방향 셀프 어텐션을 모두 활용할 수 있음

14.3 언어모델을 이용한 사전학습과 미세조정학습

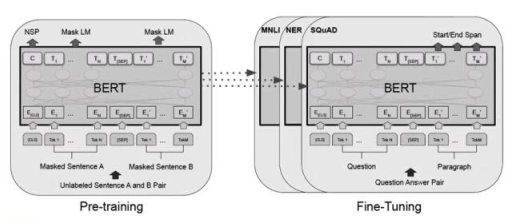

- 사전학습: 언어에 대한 이해를 높이기 위한 비지도학습

- 미세조정학습: 실제 수행하고자 하는 작업에 대한 지도학습

- BERT는 'masking', 단어를 가리고, 가린 단어를 예측하게 하는 것으로 언어 모델을 학습

- BERT에서 두 문장에 대한 학습 목표는 순서를 맞히는 것

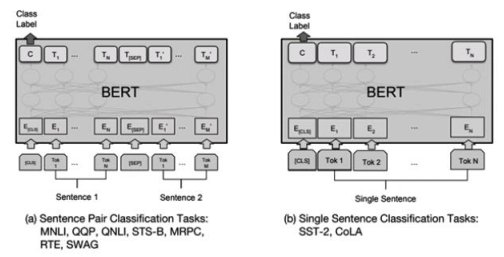

- SST-2(Stanford Sentiment Treebank): 감성분석을 위한 영화리뷰 공개 데이터셋으로 학술논문에서 성능을 평가하는 데 많이 쓰임

- CoLA(Corpus of Linguistic Acceptability): 영어 문장이 언어학적으로 올바른지 그렇지 않은지를 판단하는 데이터셋

- MNLI(Multi-Genre Natural Language Inference): 전제와 가설로 이루어진 한쌍의 문장에 대해 둘 간의 관계가 함의, 모순, 중립 중 어디에 해당하는지 분류하는 문제를 다르는 데이터셋

※ 해당 내용은 <파이썬 텍스트 마이닝 완벽 가이드>의 내용을 토대로 학습하며 정리한 내용입니다.

반응형

'텍스트 마이닝' 카테고리의 다른 글

| BERT 사전학습 모형에 대한 미세조정학습 (1) (0) | 2023.08.02 |

|---|---|

| BERT의 이해와 간단한 활용 (2) (0) | 2023.08.01 |

| 어텐션(Attention)과 트랜스포머 (2) (0) | 2023.07.30 |

| 어텐션(Attention)과 트랜스포머 (1) (0) | 2023.07.29 |

| CNN - 이미지 분류를 응용한 문서 분류 (1) (0) | 2023.07.28 |